- Son Dakika

- Gündem

- Ekonomi

- Finans

- Yazarlar

- Sektörel

- Dünya

- Kültür-Sanat

- Teknoloji

- FOTOĞRAF GALERİSİ

- VİDEO GALERİSİ

- e-Gazete

Gelişmelerden haberdar olmak için İstanbul Ticaret Haberleri uygulamasını indirin

Yapay zeka teknolojilerinin endüstriyel ve ticari kullanımı yaygınlaşırken, büyük dil modellerinin (LLM) gerektirdiği yüksek enerji ve bellek kapasitesi önemli bir maliyet kalemi oluşturmaya devam ediyor. Bu darboğazı aşmak için çalışan Edinburgh Üniversitesi ve teknoloji devi NVIDIA uzmanları, yapay zeka modellerinde verimliliği kökten değiştirecek yeni bir yöntem geliştirdi.

Geliştirilen yöntem, yapay zeka modellerinin karmaşık görevlerdeki doğruluğunu artırmakla kalmıyor, aynı zamanda önemli ölçüde enerji tasarrufu vadediyor. Araştırma sonuçlarına göre, sıkıştırılmamış bir modele kıyasla sekiz kat daha az bellek kullanan modeller, matematik, fen ve kodlama testlerinde çok daha başarılı sonuçlar elde etti.

‘DİNAMİK’ ÇÖZÜM: DMS TEKNOLOJİSİ

Yapay zeka modellerinin problem çözme yeteneği, ‘akıl yürütme dizileri’ üzerinden ilerler. Ancak modelin belleği (KV önbelleği), oluşturulan verileri depolarken bir darboğaz yaratır ve işlem sürecini yavaşlatır.

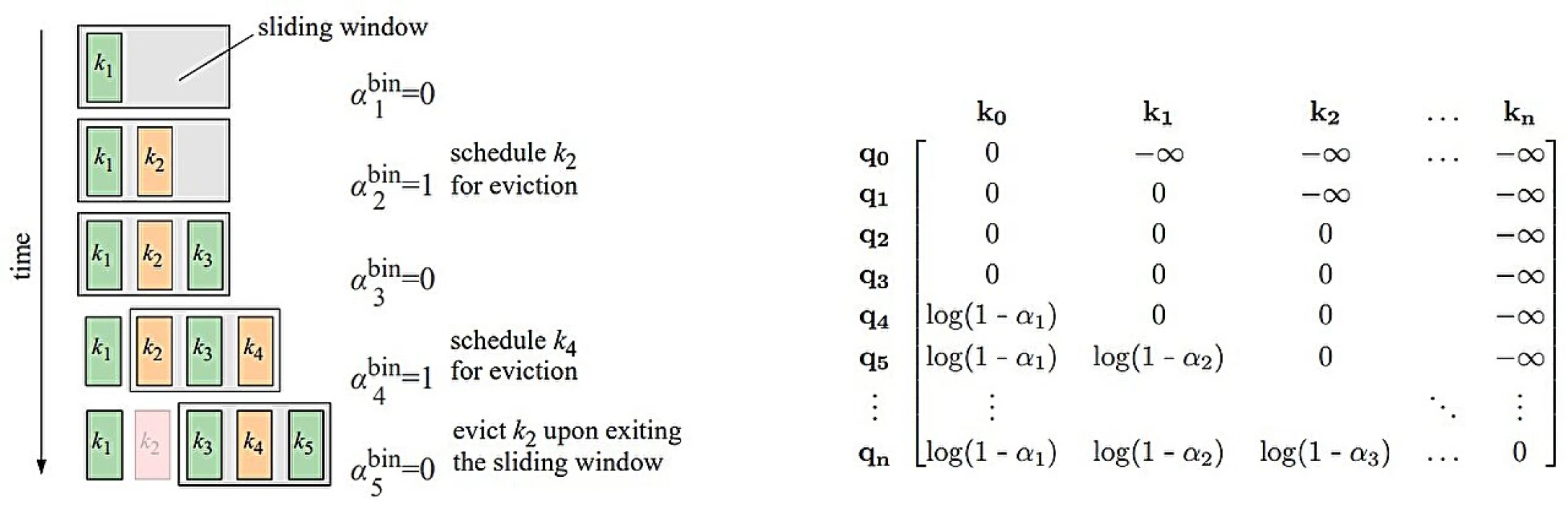

Bu sorunu çözmek için ekip, ‘Dinamik Bellek Seyreltme’ (DMS) adı verilen bir teknik geliştirdi. DMS, her bir veri birimini (belirteç/token) saklamak yerine, hangilerinin hayati önem taşıdığına karar vererek gereksiz olanları siliyor.

Sistemin en yenilikçi yönü ise silme işlemindeki stratejisi. Karar anı ile silme anı arasında bırakılan hafif gecikme sayesinde, silinecek belirteçlerdeki değerli bilgiler, korunan belirteçlere aktarılıyor. Bu sayede model, ek işlemci gücüne ihtiyaç duymadan daha derinlemesine ‘düşünme’ ve alternatif çözümleri tarama kapasitesine erişiyor.

MATEMATİK VE KODLAMADA REKOR ARTIŞ

Araştırmacılar, DMS yöntemini Llama ve Qwen gibi popüler yapay zeka modelleri üzerinde test etti. Standartlaştırılmış testlerde elde edilen sonuçlar, teknolojinin potansiyelini gözler önüne serdi:

GİYİLEBİLİR TEKNOLOJİLER İÇİN FIRSAT

Edinburgh Üniversitesi Bilişim Fakültesi Öğretim Üyesi Dr. Edoardo Ponti, "Modellerimiz aynı kalitede daha hızlı akıl yürütme yapabiliyor. Bu da matematik, bilim ve kodlamadaki karmaşık problemleri çözme yeteneklerini geliştiriyor" değerlendirmesinde bulundu.

Bu teknoloji sadece dev sunucular için değil, sınırlı belleğe sahip cihazlar için de büyük önem taşıyor. Enerji verimliliği sağlayan bu yöntem sayesinde, akıllı ev cihazları ve giyilebilir teknolojilerde çok daha gelişmiş yapay zeka modellerinin çalıştırılması mümkün hale gelecek. Yöntem ayrıca, aynı sunucu kapasitesiyle daha fazla kullanıcı sorgusuna yanıt verilmesinin de önünü açıyor.