- Son Dakika

- Gündem

- Ekonomi

- Finans Ekstra+

- Yazarlar

- Sektörel

- Dünya

- Kültür-Sanat

- Teknoloji

- FOTOĞRAF GALERİSİ

- VİDEO GALERİSİ

- e-Gazete

Gelişmelerden haberdar olmak için İstanbul Ticaret Haberleri uygulamasını indirin

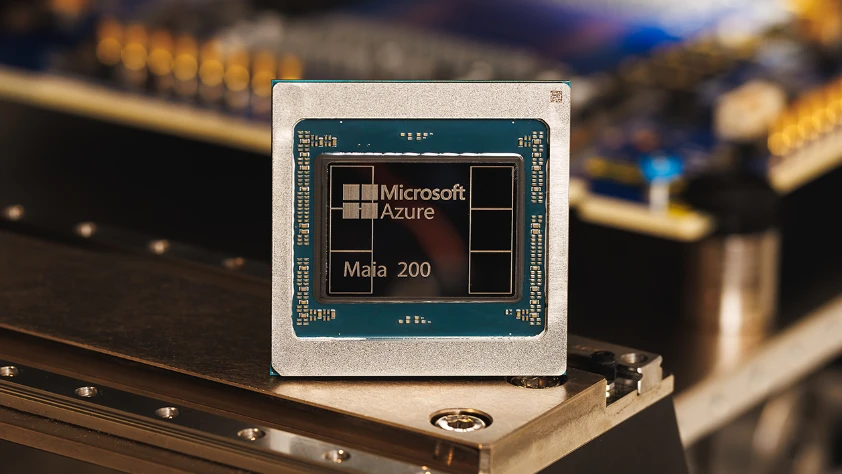

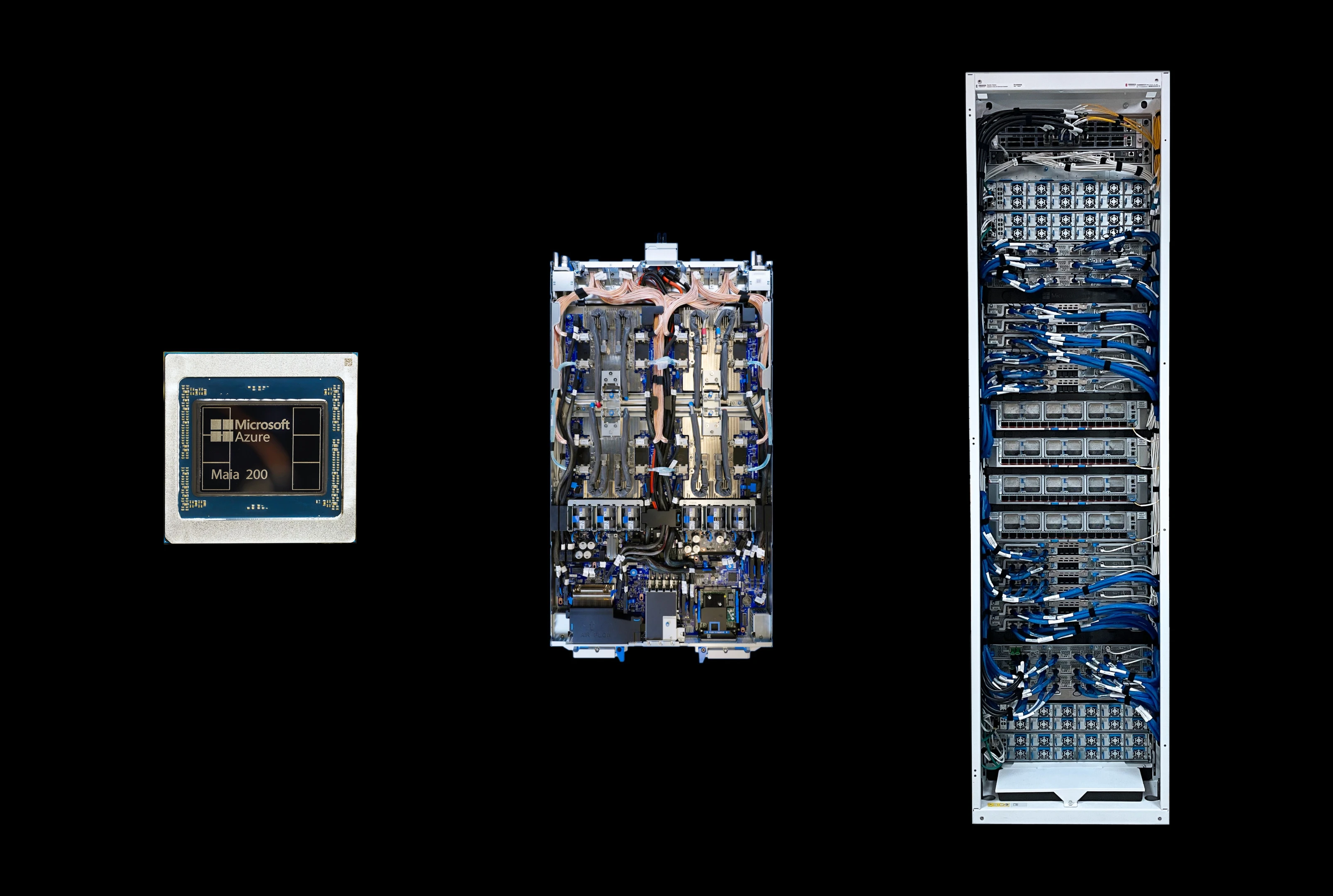

Yapay zeka sektöründe rekabet, sadece yazılım değil, donanım altyapısı üzerinden de hız kazanıyor. Microsoft, büyük dil modellerinin (LLM) çalıştırılma maliyetlerini düşürmek ve operasyonel verimliliği artırmak amacıyla tasarladığı Maia 200 işlemcisini tanıttı. Önceki nesil Maia 100’ün üzerine inşa edilen yeni sürüm, çıkarım (inference) süreçlerinde devrim yaratmayı hedefliyor.

ODAK NOKTASI: OPERASYONEL VERİMLİLİK VE ÇIKARIM

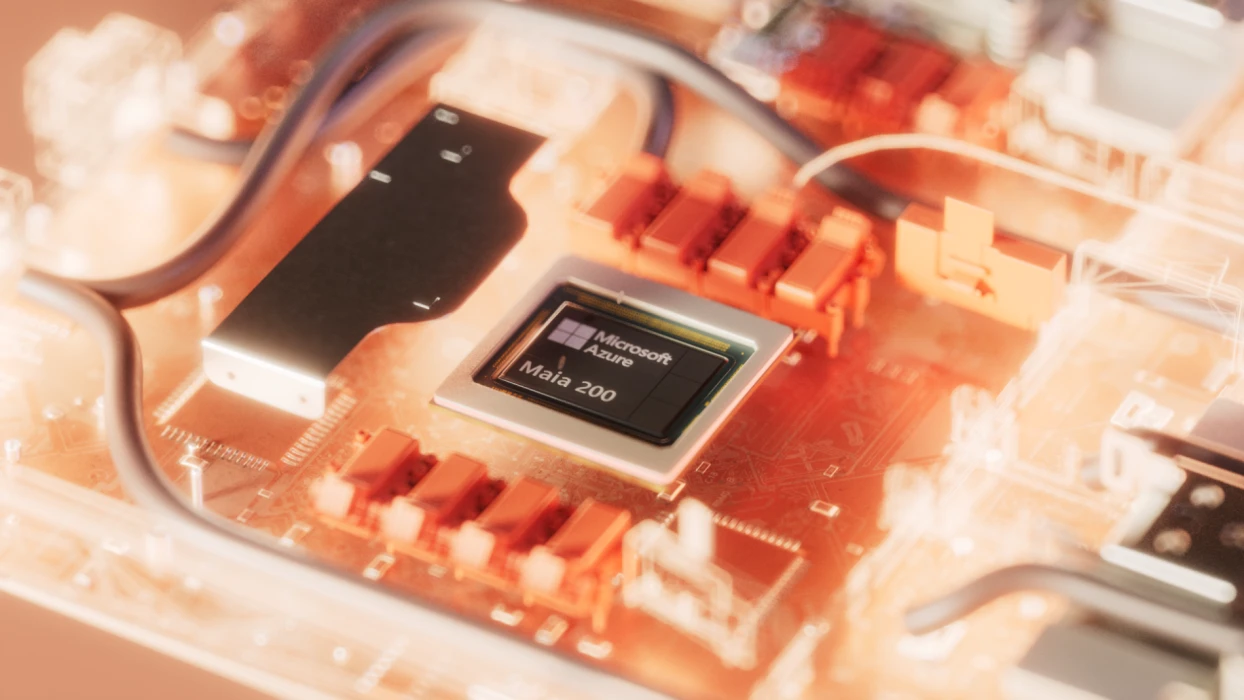

Yapay zeka sistemleri için ‘çıkarım’ süreci, modellerin kullanıcı sorularına yanıt verme aşaması olarak tanımlanıyor. Sohbet botları ve Copilot gibi servislerin milyonlarca kullanıcıya ulaşmasıyla birlikte bu süreç, şirketler için en büyük gider kalemlerinden biri haline geldi. Microsoft, Maia 200’ün tam olarak bu yüksek trafikli ve kesintisiz çalışma gerektiren iş yükleri için tasarlandığını vurguluyor.

Yeni çip, bu hafta itibarıyla Iowa’daki Microsoft veri merkezinde devreye alınırken; şirketin bir sonraki durağının Arizona olacağı belirtildi.

TEKNİK KAPASİTE VE PERFORMANS VERİLERİ

Maia 200, teknolojik imkanların sınırlarını zorlayan bir donanım mimarisine sahip. Microsoft tarafından paylaşılan teknik detaylar, çipin sektördeki rakiplerine karşı güçlü bir pozisyon aldığını gösteriyor:

Özellik | Detay |

Transistör Sayısı | 100 Milyardan fazla |

Üretim Teknolojisi | 3 Nanometre (TSMC) |

İşlem Gücü (FP4) | 10 Petaflops+ |

İşlem Gücü (FP8) | ~5 Petaflops |

Bellek Tipi | Yüksek Hızlı SRAM ve HBM |

Çip, tekrarlanan sorgulardaki gecikmeleri minimize etmek için geniş bir SRAM kapasitesiyle donatıldı. Bu mimari, kullanıcı trafiğinin en yoğun olduğu anlarda bile milisaniyeler düzeyinde hızlı yanıt verilmesine olanak tanıyor.

STRATEJİK HEDEF: NVIDIA BAĞIMLILIĞINI AZALTMAK

Microsoft’un bu hamlesi, teknoloji dünyasında stratejik bir bağımsızlık ilanı olarak yorumlanıyor. Halihazırda yapay zeka altyapısına hakim olan NVIDIA’nın pazar baskısını kırmak isteyen bulut sağlayıcıları (Google, Amazon, Microsoft), kendi çiplerini geliştirerek hem maliyetleri kontrol etmek hem de tedarik zinciri risklerini yönetmek istiyor.

Microsoft yetkilileri, Maia 200'ün Amazon’un üçüncü nesil Trainium çiplerine kıyasla üç kat daha yüksek FP4 performansı sunduğunu ve Google’ın en yeni TPU’larından (Tensor İşlem Birimi) daha güçlü olduğunu iddia ediyor.

YAZILIMDA YENİ STANDART: TRITON

Donanımın yanı sıra yazılım ekosisteminde de rekabet kızışıyor. Microsoft, NVIDIA'nın baskın programlama platformu CUDA'ya alternatif olarak, OpenAI'ın da katkı sağladığı açık kaynaklı Triton çerçevesini konumlandırıyor. Geliştiricilerin daha verimli kod yazmasına imkan tanıyan bu araç seti, Maia 200'ün potansiyelini maksimize etmek için kritik bir rol oynuyor.

Halihazırda Microsoft’un kendi Copilot servislerine ve Süper Zeka ekibinin modellerine güç sağlayan Maia 200; akademisyenler, geliştiriciler ve öncü yapay zeka laboratuvarlarının testine sunulmuş durumda. Bu gelişme, yapay zeka altyapısında sadece hızın değil, dağıtım ve yazılım kontrolünün de ne kadar hayati olduğunu bir kez daha kanıtlıyor.