- Son Dakika

- Gündem

- Ekonomi

- Finans

- Yazarlar

- Sektörel

- Dünya

- Kültür-Sanat

- Teknoloji

- FOTOĞRAF GALERİSİ

- VİDEO GALERİSİ

- e-Gazete

Gelişmelerden haberdar olmak için İstanbul Ticaret Haberleri uygulamasını indirin

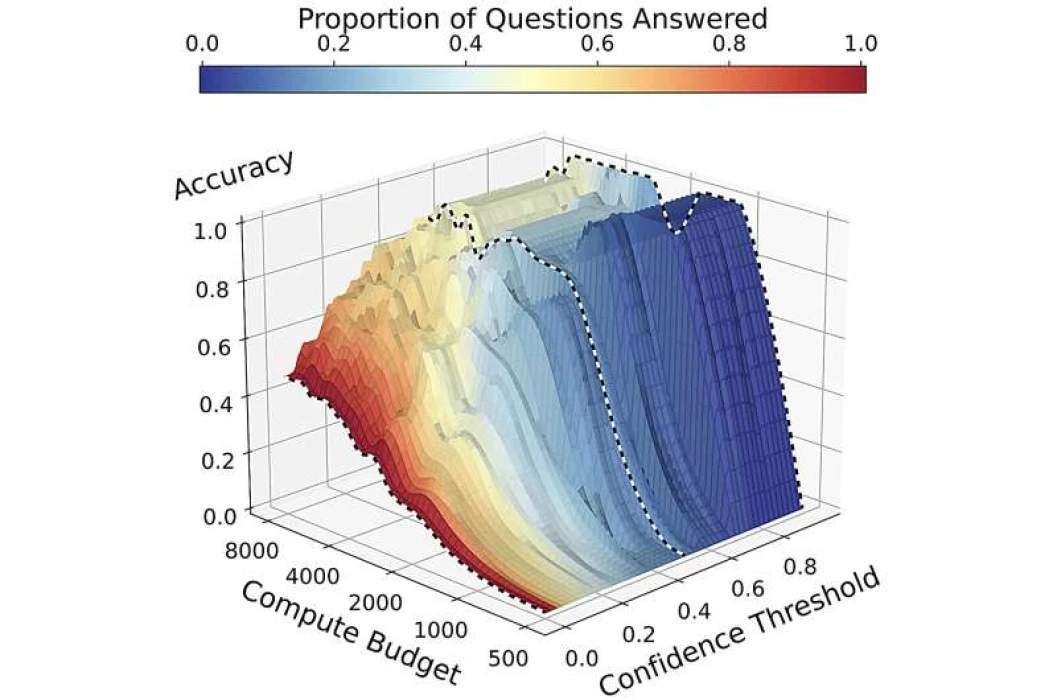

Yüksek riskli ortamlarda çalışan yapay zeka sistemlerinin, emin olmadıkları sorulara yanlış cevap vermek yerine “bilmiyorum” yanıtını tercih etmesi gerekebilir. Johns Hopkins Üniversitesi’nden araştırmacılar, bu ihtiyaca cevap veren yeni bir yaklaşım geliştirdi. Sistem, bir soruyu yanıtlamadan önce düşünme süresi tanıyor ve yeterli güven oluşmadığında cevaptan kaçınıyor.

GÜVEN EŞİĞİ BELİRLİYOR

Geliştirilen yöntem, yapay zekaya verilen ‘düşünme süresi’ uzadıkça cevaba olan güvenin nasıl değiştiğini analiz ediyor. Bu yaklaşımda, sistemin cevap verip vermeyeceğine karar vermesi için bir güven eşiği tanımlanıyor. Yani model, ancak belirli bir güven seviyesini aştığında yanıt üretiyor; aksi takdirde “bilmiyorum” diyor.

YÜKSEK RİSKTE DENGELİ KARAR

Araştırmalar, düşünme süresi artırıldığında hem doğru hem de yanlış cevap sayısının arttığını ortaya koydu. Bu da yapay zekanın yanıt vermesi için sadece doğruluğa değil, ortamın risk seviyesine göre belirlenen maliyet dengesine göre hareket etmesi gerektiğini gösteriyor.

FARKLI SENARYOLAR İÇİN MODELLER

Ekip, üç farklı senaryo için oran modelleri geliştirdi: sınav ortamları (yanlış cevaba ceza yok), “Jeopardy!” tarzı yarışmalar (doğru ve yanlış eşit ağırlıklı) ve yüksek riskli uygulamalar (yanlış cevap daha ağır cezalara yol açıyor). Bu senaryolar altında, sistemin “bilmiyorum” deme sıklığı ayarlanabiliyor.

YENİ ARAŞTIRMA YOLU AÇILIYOR

Araştırmacılar, AI araştırma topluluğunu, bu farklı oran modelleri altında sistem performanslarını raporlamaya teşvik ediyor. Bu yaklaşımın, belirsizlik ölçümü için daha gelişmiş yöntemlerin geliştirilmesine katkı sağlayabileceği belirtiliyor.

Johns Hopkins’in geliştirdiği bu güven tabanlı model, yapay zekanın yüksek hassasiyet gerektiren görevlerde daha sorumlu ve güvenli kullanılmasının önünü açabilir. Sistem, doğru cevaplara ulaşma çabasını sürdürürken, yanlış bilgiden kaçınma sorumluluğunu da üstlenmiş oluyor.